Es el procesamiento de la información realizada por los programas, por ejemplo.

Consta de 3 instancias:

Entrada de informacion;

Procesamiento de informacion;

Salida de informacion como respuesta a los datos que ingresamos

Informática e Internet

Un blog creado para informar sobre diferentes terminos informáticos

jueves, 10 de noviembre de 2011

miércoles, 9 de noviembre de 2011

Sistema Operativo

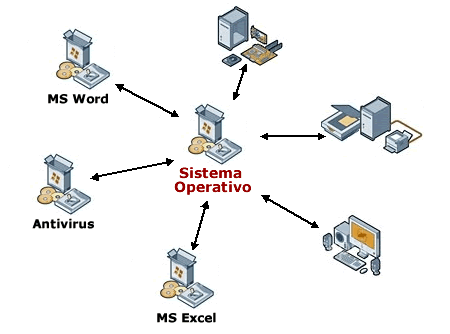

Un sistema operativo (SO) es el programa o conjunto de programas que efectúan la gestión de los procesos básicos de un sistema informático, y permite la normal ejecución del resto de las operaciones.

Nótese que es un error común muy extendido denominar al conjunto completo de herramientas sistema operativo, es decir, la inclusión en el mismo término de programas como el explorador de ficheros, el navegador y todo tipo de herramientas que permiten la interacción con el sistema operativo, también llamado núcleo o kernel. Uno de los más prominentes ejemplos de esta diferencia, es el núcleo Linux, que es el núcleo del sistema operativo GNU, del cual existen las llamadas distribuciones GNU. Este error de precisión, se debe a la modernización de la informática llevada a cabo a finales de los 80, cuando la filosofía de estructura básica de funcionamiento de los grandes computadores se rediseñó a fin de llevarla a los hogares y facilitar su uso, cambiando el concepto de computador multiusuario, (muchos usuarios al mismo tiempo) por un sistema monousuario (únicamente un usuario al mismo tiempo) más sencillo de gestionar. AmigaOS, beOS o MacOS como los pioneros de dicha modernización, cuando los Amiga, fueron bautizados con el sobrenombre de Video Toasters por su capacidad para la Edición de vídeo en entorno multitarea round robin, con gestión de miles de colores e interfaces intuitivos para diseño en 3D.

Nótese que es un error común muy extendido denominar al conjunto completo de herramientas sistema operativo, es decir, la inclusión en el mismo término de programas como el explorador de ficheros, el navegador y todo tipo de herramientas que permiten la interacción con el sistema operativo, también llamado núcleo o kernel. Uno de los más prominentes ejemplos de esta diferencia, es el núcleo Linux, que es el núcleo del sistema operativo GNU, del cual existen las llamadas distribuciones GNU. Este error de precisión, se debe a la modernización de la informática llevada a cabo a finales de los 80, cuando la filosofía de estructura básica de funcionamiento de los grandes computadores se rediseñó a fin de llevarla a los hogares y facilitar su uso, cambiando el concepto de computador multiusuario, (muchos usuarios al mismo tiempo) por un sistema monousuario (únicamente un usuario al mismo tiempo) más sencillo de gestionar. AmigaOS, beOS o MacOS como los pioneros de dicha modernización, cuando los Amiga, fueron bautizados con el sobrenombre de Video Toasters por su capacidad para la Edición de vídeo en entorno multitarea round robin, con gestión de miles de colores e interfaces intuitivos para diseño en 3D.Uno de los propósitos del sistema operativo que gestiona el núcleo intermediario consiste en gestionar los recursos de localización y protección de acceso del hardware, hecho que alivia a los programadores de aplicaciones de tener que tratar con estos detalles. La mayoría de aparatos electrónicos que utilizan microprocesadores para funcionar, llevan incorporado un sistema operativo. (teléfonos móviles, reproductores de DVD, computadoras, radios, enrutadores, etc).

Llamadas al sistema operativo

Definición breve: llamadas que ejecutan los programas de aplicación para pedir algún servicio al SO.

Cada SO implementa un conjunto propio de llamadas al sistema. Ese conjunto de llamadas es la interfaz del SO frente a las aplicaciones. Constituyen el lenguaje que deben usar las aplicaciones para comunicarse con el SO. Por ello si cambiamos de SO, y abrimos un programa diseñado para trabajar sobre el anterior, en general el programa no funcionará, a no ser que el nuevo SO tenga la misma interfaz. Para ello:

Las llamadas correspondientes deben tener el mismo formato.

Cada llamada al nuevo SO tiene que dar los mismos resultados que la correspondiente del anterior.

Modos de ejecución en un CPU

Las aplicaciones no deben poder usar todas las instrucciones de la CPU. No obstante el Sistema Operativo, tiene que poder utilizar todo el juego de instrucciones del CPU. Por ello, una CPU debe tener (al menos) dos modos de operación diferentes:

Modo usuario: el CPU podrá ejecutar sólo las instrucciones del juego restringido de las aplicaciones.

Modo supervisor: la CPU debe poder ejecutar el juego completo de instrucciones.

Llamadas al sistema

Una aplicación, normalmente no sabe dónde está situada la rutina de servicio de la llamada. Por lo que si ésta se codifica como una llamada de función, cualquier cambio en el S.O. haría que hubiera que reconstruir la aplicación.

Pero lo más importante es que una llamada de función no cambia el modo de ejecución de la CPU. Con lo que hay que conseguir llamar a la rutina de servicio, sin tener que conocer su ubicación, y hacer que se fuerce un cambio de modo de operación de la CPU en la llamada (y la recuperación del modo anterior en el retorno).

Esto se hace utilizando instrucciones máquina diseñadas específicamente para este cometido, distintas de las que se usan para las llamadas de función.

Bibliotecas de interfaz de llamadas al sistema

Las llamadas al sistema no siempre tienen una expresión sencilla en los lenguajes de alto nivel, por ello se crean las bibliotecas de interfaz, que son bibliotecas de funciones que pueden usarse para efectuar llamadas al sistema. Las hay para distintos lenguajes de programación.

La aplicación llama a una función de la biblioteca de interfaz (mediante una llamada normal) y esa función es la que realmente hace la llamada al sistema.

El SO ocupa una posición intermedia entre los programas de aplicación y el hardware. No se limita a utilizar el hardware a petición de las aplicaciones ya que hay situaciones en las que es el hardware el que necesita que se ejecute código del SO. En tales situaciones el hardware debe poder llamar al sistema, pudiendo deberse estas llamadas a dos condiciones:

Algún dispositivo de E/S necesita atención.

Se ha producido una situación de error al intentar ejecutar una instrucción del programa (normalmente de la aplicación).

En ambos casos, la acción realizada no está ordenada por el programa de aplicación, es decir, no figura en el programa.

Según los dos casos anteriores tenemos las interrupciones y la excepciones:

Interrupción: señal que envía un dispositivo de E/S a la CPU para indicar que la operación de la que se estaba ocupando, ya ha terminado.

Excepción: una situación de error detectada por la CPU mientras ejecutaba una instrucción, que requiere tratamiento por parte del SO.

Clasificación

Administración de tareas:

Monotarea: Solamente puede ejecutar un proceso (aparte de los procesos del propio S.O.) en un momento dado. Una vez que empieza a ejecutar un proceso, continuará haciéndolo hasta su finalización y/o interrupción.

Multitarea: Es capaz de ejecutar varios procesos al mismo tiempo. Este tipo de S.O. normalmente asigna los recursos disponibles (CPU, memoria, periféricos) de forma alternada a los procesos que los solicitan, de manera que el usuario percibe que todos funcionan a la vez, de forma concurrente.

Administración de usuarios

Monousuario: Si sólo permite ejecutar los programas de un usuario al mismo tiempo.

Multiusuario: Si permite que varios usuarios ejecuten simultáneamente sus programas, accediendo a la vez a los recursos de la computadora. Normalmente estos sistemas operativos utilizan métodos de protección de datos, de manera que un programa no pueda usar o cambiar los datos de otro usuario.

Manejo de recursos

Centralizado: Si permite usar los recursos de una sola computadora.

Distribuido: Si permite utilizar los recursos (memoria, CPU, disco, periféricos... ) de más de una computadora al mismo tiempo.

Ejemplos de Sistemas Operativos ( ordenadores )

- Windows

Mac OS

Linux

AmigaOS

Unix

Digitalización

La digitalización es el proceso mediante el cual, partiendo de una señal analógica, como es cualquiera de las imágenes que nos rodean en el mundo real, obtenemos una representación de la misma en formato digital (señal digital). Debido al desgaste que sufren las cintas tales como Super 8, 16 mm y 35 mm, este proceso a tomado mucho auge en la actualidad, incluso desarrollándose compañías especializadas en ello.La digitalización de una imagen se basa a una división del espacio a modo de cuadrícula, donde la unidad más pequeña se denomina píxel. Para cada uno de los pixels que tenemos en una imagen hay que guardar la información referente a la luminancia (brillo o niveles de gris) y, si es en color, también al nivel de cada una de las componentes, R(rojo), G(verde) y B(azul). Por tanto vemos que para una imagen tendremos varias matrices de información.

Cuando hablamos de digitalización de video debemos tener en cuenta que entra en juego una tercera dimensión, el tiempo. Por tanto una secuencia de video se genera mediante la proyección de un número de imágenes en un tiempo determinado, que dependerá del sistema sobre el que trabajemos (24 imágenes/segundo en cine, 25/s en el sistema PAL...). El problema de este planteamiento es el alto volumen de datos que se crean. Es por esto que se han desarrollado varios estándares de codificación y compresión como es la familia MPEG entre otros que permiten obtener una alta calidad de video a la vez que diferentes tasas para diversas aplicaciones.

Cuando hablamos de digitalización de video debemos tener en cuenta que entra en juego una tercera dimensión, el tiempo. Por tanto una secuencia de video se genera mediante la proyección de un número de imágenes en un tiempo determinado, que dependerá del sistema sobre el que trabajemos (24 imágenes/segundo en cine, 25/s en el sistema PAL...). El problema de este planteamiento es el alto volumen de datos que se crean. Es por esto que se han desarrollado varios estándares de codificación y compresión como es la familia MPEG entre otros que permiten obtener una alta calidad de video a la vez que diferentes tasas para diversas aplicaciones.Pero para obtener una imagen digital debemos tener en cuenta varios pasos:

- Muestreo: La importancia de esta parte del proceso es evidente. Es el único momento en el que tenemos contacto con la imagen original, o señal analógica, y es cuando decidimos con cuánta información queremos quedarnos. Es irreversible, puesto que toda aquella información que desechemos ya no podremos recuperarla y, por tanto, la calidad de la imagen digital que generemos se verá afectada por el criterio que seleccionemos.

Antes de muestrear una señal analógica, para evitar el posible efecto aliasing o solapamiento de los términos espectrales, debemos cumplir dos requisitos fundamentales:

-Limitar la imagen en una banda de frecuencias

-Cumplir que la frecuencia de muestreo sea como mínimo el doble de la máxima frecuencia de la imagen (Teorema de Nyquist)

Generalmente, pero dentro de ciertos límites, el aumento de la frecuencia de muestreo también ayuda a aumentar la resolución.

Cuantificación : Es el proceso mediante el cual se decide, para cada rango de colores (mundo analógico), cual va a ser el color con el que va a ser representado en la imagen final. Por tanto, cuantos más niveles se tengan definidos mejor será la calidad. El problema que presenta es que, a mayor nivel de definición, mayor será el volumen de datos que deberemos guardar por cada uno de los pixels.

La transformación realizada es también irreversible, perderemos colores.

El cuantificador más sencillo es el uniforme, aunque existen otros como el de Max-Lloyd que minimizan el error cuadrático medio.

- Codificación : Es el proceso de conversión de los valores cuantificados al sistema binario donde la organización final de los “bits” dependerá del formato que se escoja.

Sistema Binario

El sistema binario, en matemáticas e informática, es un sistema de numeración en el que los números se representan utilizando solamente las cifras cero y uno (0 y 1). Es el que se utiliza en las computadoras, debido a que trabajan internamente con dos niveles de voltaje, por lo cual su sistema de numeración natural es el sistema binario (encendido 1, apagado 0).

El sistema binario, en matemáticas e informática, es un sistema de numeración en el que los números se representan utilizando solamente las cifras cero y uno (0 y 1). Es el que se utiliza en las computadoras, debido a que trabajan internamente con dos niveles de voltaje, por lo cual su sistema de numeración natural es el sistema binario (encendido 1, apagado 0).Representación

Un número binario puede ser representado por cualquier secuencia de bits (dígitos binarios), que suelen representar cualquier mecanismo capaz de estar en dos estados mutuamente excluyentes. Las siguientes secuencias de símbolos podrían ser interpretadas como el mismo valor numérico binario:

1 0 1 0 0 1 1 0 1 0 | - | - - | | - | - x o x o o x x o x o y n y n n y y n y n

El valor numérico representado en cada caso depende del valor asignado a cada símbolo. En una computadora, los valores numéricos pueden representar dos voltajes diferentes; también pueden indicar polaridades magnéticas sobre un disco magnético. Un "positivo", "sí", o "sobre el estado" no es necesariamente el equivalente al valor numérico de uno; esto depende de la nomenclatura usada.

De acuerdo con la representación más habitual, que es usando números árabes, los números binarios comúnmente son escritos usando los símbolos 0 y 1. Los números binarios se escriben a menudo con subíndices, prefijos o sufijos para indicar su base. Las notaciones siguientes son equivalentes:

100101 binario (declaración explícita de formato)

100101b (un sufijo que indica formato binario)

100101B (un sufijo que indica formato binario)

bin 100101 (un prefijo que indica formato binario)

1001012 (un subíndice que indica base 2 (binaria) notación)

%100101 (un prefijo que indica formato binario)

0b100101 (un prefijo que indica formato binario, común en lenguajes de programación)

Conversión entre binario y decimal

Decimal a binario: Se divide el numero del sistema decimal 2, cuyo resultado entero se vuelve a dividir entre 2, y así sucesivamente hasta que el dividendo sea menor que el divisor, 2. Es decir, cuando el número a dividir sea 1 finaliza la división.

A continuación se ordenan los restos empezando desde el último al primero, simplemente se colocan en orden inverso a como aparecen en la división, se les da la vuelta.

Otra forma de conversión consiste en un método parecido a la factorización en números primos. Es relativamente fácil dividir cualquier número entre 2. Este método consiste también en divisiones sucesivas. Dependiendo de si el número es par o impar, colocaremos un cero o un uno en la columna de la derecha. Si es impar, le restaremos uno y seguiremos dividiendo entre dos, hasta llegar a 1. Después sólo nos queda tomar el último resultado de la columna izquierda (que siempre será 1) y todos los de la columna de la derecha y ordenar los dígitos de abajo a arriba.Existe un último método denominado de distribución. Consiste en distribuir los unos necesarios entre las potencias sucesivas de 2 de modo que su suma resulte ser el número decimal a convertir. Sea por ejemplo el número 151, para el que se necesitarán las 8 primeras potencias de 2, ya que la siguiente, 28=256, es superior al número a convertir. Se comienza poniendo un 1 en 128, por lo que aún faltarán 23, 151-128 = 23, para llegar al 151. Este valor se conseguirá distribuyendo unos entre las potencias cuya suma dé el resultado buscado y poniendo ceros en el resto. En el ejemplo resultan ser las potencias 4, 2, 1 y 0, esto es, 16, 4, 2 y 1, respectivamente.

Periféricos

En informática, se denomina periféricos a los aparatos o dispositivos auxiliares e independientes conectados a la unidad central de procesamiento de una computadora.

En informática, se denomina periféricos a los aparatos o dispositivos auxiliares e independientes conectados a la unidad central de procesamiento de una computadora.A pesar de que el término periférico implica a menudo el concepto de “adicional pero no esencial”, muchos de ellos son elementos fundamentales para un sistema informático. El teclado y el monitor, imprescindibles en cualquier computadora personal de hoy en día (no lo fueron en los primeros computadores), son posiblemente los periféricos más comunes, y es posible que mucha gente no los considere como tal debido a que generalmente se toman como parte necesaria de una computadora. El ratón o mouse es posiblemente el ejemplo más claro de este aspecto.

Tipos de perifericos: Los periféricos pueden clasificarse en 5 categorías principales:

Periféricos de entrada: captan y digitalizan los datos de ser necesario, introducidos por el usuario o por otro dispositivo y los envían al ordenador para ser procesados. Son los que permiten introducir datos externos a la computadora para su posterior tratamiento por parte de la CPU. Estos datos pueden provenir de distintas fuentes, siendo la principal un ser humano. Los periféricos de entrada más habituales son:

Periféricos de entrada: captan y digitalizan los datos de ser necesario, introducidos por el usuario o por otro dispositivo y los envían al ordenador para ser procesados. Son los que permiten introducir datos externos a la computadora para su posterior tratamiento por parte de la CPU. Estos datos pueden provenir de distintas fuentes, siendo la principal un ser humano. Los periféricos de entrada más habituales son:Teclado

Micrófono

Escáner

Ratón o mouse

Escáner de código de barras

Cámara web

Lápiz óptico

Cámara digital

Periféricos de salida: son dispositivos que muestran o proyectan información hacia el exterior del ordenador. La mayoría son para informar, alertar, comunicar, proyectar o dar al usuario cierta información, de la misma forma se encargan de convertir los impulsos eléctricos en información legible para el usuario. Sin embargo, no todos de este tipo de periféricos es información para el usuario. Son los que reciben la información procesada por la CPU y la reproducen, de modo que sea perceptible por el usuario. Algunos ejemplos son:

Periféricos de salida: son dispositivos que muestran o proyectan información hacia el exterior del ordenador. La mayoría son para informar, alertar, comunicar, proyectar o dar al usuario cierta información, de la misma forma se encargan de convertir los impulsos eléctricos en información legible para el usuario. Sin embargo, no todos de este tipo de periféricos es información para el usuario. Son los que reciben la información procesada por la CPU y la reproducen, de modo que sea perceptible por el usuario. Algunos ejemplos son:Visualizador

Monitor

Impresora

Fax

Tarjeta de sonido

Altavoz

Proyector Digital

Audífonos

Periféricos de entrada/salida (E/S): sirven básicamente para la comunicación de la computadora con el medio externo.

Los periféricos de entrada/salida son los que utiliza el ordenador tanto para mandar como para recibir información. Su función es la de almacenar o guardar, de forma permanente o virtual, todo aquello que hagamos con el ordenador para que pueda ser utilizado por los usuarios u otros sistemas.

Son ejemplos de periférico de entrada/salida o de almacenamiento:

Son ejemplos de periférico de entrada/salida o de almacenamiento:Disco duro

Grabadora y/o lector de CD

Grabadora y/o lector de DVD

Impresora

Memoria flash

Cintas magnéticas

Memoria portátil

Disquete

Pantalla táctil

Casco virtual

Grabadora y/o lector de CD

Grabadora y/o lector de DVD

Grabadora y/o lector de Blu-ray

Grabadora y/o lector de HD-DVD Periféricos de almacenamiento: son los dispositivos que almacenan datos e información por bastante tiempo. La memoria de acceso aleatorio no puede ser considerada un periférico de almacenamiento, ya que su memoria es volátil y temporal. Se encargan de guardar los datos de los que hace uso la CPU, para que ésta pueda hacer uso de ellos una vez que han sido eliminados de la memoria principal, ya que ésta se borra cada vez que se apaga la computadora. Pueden ser internos, como un disco duro, o extraíbles, como un CD. Los más comunes son:

Disquete

Unidad de CD

Unidad de DVD

Unidad de Blu-ray Disc

Memoria flash

Memoria USB

Cinta magnética

Tarjeta perforada

Memoria portátil

Otros dispositivos de almacenamiento:

Zip (Iomega): Caben 100 Mb y utiliza tecnología magnética.

EZFlyer (SyQuest): Caben 230 Mb y tiene una velocidad de lectura muy alta

SuperDisk LS-120: Caben 200 Mb y utilizan tecnología magneto-óptica.

Magneto-ópticos de 3,5: Caben de 128 Mb a 640 Mb

Jaz (Iomega): Similar al dispositivo Zip y con capacidad de 1 GB a 2 GB.

Periféricos de comunicación: son los periféricos que se encargan de comunicarse con otras máquinas o computadoras, ya sea para trabajar en conjunto, o para enviar y recibir información. Su función es permitir o facilitar la interacción entre dos o más computadoras, o entre una computadora y otro periférico externo a la computadora. Entre ellos se encuentran los siguientes:

Periféricos de comunicación: son los periféricos que se encargan de comunicarse con otras máquinas o computadoras, ya sea para trabajar en conjunto, o para enviar y recibir información. Su función es permitir o facilitar la interacción entre dos o más computadoras, o entre una computadora y otro periférico externo a la computadora. Entre ellos se encuentran los siguientes:Fax-Módem

Tarjeta de red

Concentrador

Conmutador

Enrutador

Tarjeta inalámbrica

Tarjeta Bluetooth

Sistema informático

Un sistema informático como todo sistema, es el conjunto de partes interrelacionadas, hardware, software y de recurso humano (humanware) que permite almacenar y procesar información. El hardware incluye computadoras o cualquier tipo de dispositivo electrónico inteligente, que consisten en procesadores, memoria, sistemas de almacenamiento externo, etc. El software incluye al sistema operativo, firmware y aplicaciones, siendo especialmente importante los sistemas de gestión de bases de datos. Por último el soporte humano incluye al personal técnico que crean y mantienen el sistema (analistas, programadores, operarios, etc.) y a los usuarios que lo utilizan.

Un sistema informático como todo sistema, es el conjunto de partes interrelacionadas, hardware, software y de recurso humano (humanware) que permite almacenar y procesar información. El hardware incluye computadoras o cualquier tipo de dispositivo electrónico inteligente, que consisten en procesadores, memoria, sistemas de almacenamiento externo, etc. El software incluye al sistema operativo, firmware y aplicaciones, siendo especialmente importante los sistemas de gestión de bases de datos. Por último el soporte humano incluye al personal técnico que crean y mantienen el sistema (analistas, programadores, operarios, etc.) y a los usuarios que lo utilizan.| |

Los sistemas informáticos pasan por diferentes fases en su ciclo de vida, desde la captura de requisitos hasta el mantenimiento. En la actualidad se emplean numerosos sistemas informáticos en la administración pública.

Los sistemas informáticos suelen estructurarse en Subsistemas:

Subsistema físico: asociado al hardware. Incluye entre otros elementos la CPU, memoria principal, la placa base, periféricos de entrada y salida, etc.

Subsistema lógico: asociado al software y la arquitectura. Incluye al sistema operativo, el firmware, las aplicaciones y las bases de datos.

Los S.I. pueden clasificarse en base a numerosos criterios. Por supuesto las clasificaciones no son estancas y es común encontrar sistemas híbridos que no encajen en una única categoría.

Por su uso pueden ser:

De uso general.

De uso específico. Por el paralelismo de los procesadores, que puede ser:

SISD: Single Instruction Single Data

SIMD: Single Instruction Multiple Data

MIMD: Multiple Instruction Multiple Data Por el tipo de ordenador utilizado en el sistema

Estaciones de trabajo (Workstations)

Terminales ligeros (Thin clients)

Microordenadores (por ejemplo ordenadores personales)

Miniordenadores (servidores pequeños)

Macroordenadores (servidores de gran capacidad)

Superordenadores Por la arquitectura

Sistema aislado :

Arquitectura cliente-servidor

Arquitectura de 3 capas

Arquitectura de n capas

Servidor de aplicaciones

Monitor de teleproceso o servidor de transacciones Tarjeta de audio y tarjeta de video

tarjeta de sonido:

Una tarjeta de sonido o placa de sonido es una tarjeta de expansión para computadoras que permite la salida de audio bajo el control de un programa informático llamado controlador (en inglés driver programa que actúa de ). El típico uso de las tarjetas de sonido consiste en proveer mediante unmezclador, que las multimedia del componente de audio suenen y puedan ser gestionadas. Estas aplicaciones multimedia engloban composición y edición de video o audio, presentaciones multimedia y entretenimiento (videojuegos). Algunos equipos (como los personales) tienen la tarjeta ya integrada, mientras que otros requieren tarjetas de expansión. También hay otro tipo de equipos que por circunstancias profesionales (como por ejemplo servidores) no requieren de dicho servicio.

Tarjeta gráfica:

Una tarjeta gráfica, tarjeta de vídeo, placa de vídeo, tarjeta aceleradora de gráficos o adaptador de pantalla, es una tarjeta de expansión para una computadora u ordenador, encargada de procesar los datos provenientes de la CPU y transformarlos en información comprensible y representable en un dispositivo de salida, como un monitor o televisor.

Las tarjetas gráficas más comunes son las disponibles para las computadoras compatibles con la IBM PC, debido a la enorme popularidad de éstas, pero otras arquitecturas también hacen uso de este tipo de dispositivos.

Es habitual que se utilice el mismo término tanto a las habituales tarjetas dedicadas y separadas como a las GPU integradas en la placa base. Algunas tarjetas gráficas han ofrecido funcionalidades añadidas como captura de vídeo, sintonización de TV, decodificación MPEG-2 y MPEG-4 o incluso conectores Firewire, de ratón, lápiz óptico o joystick.

Las tarjetas gráficas no son dominio exclusivo de los PC; contaron o cuentan con ellas dispositivos como los Commodore Amiga (conectadas mediante las ranuras Zorro II y Zorro III), Apple II, Apple Macintosh, Spectravideo SVI-328, equipos MSX y, por supuesto, en las videoconsolas modernas, como la Wii, la Playstation 3 y la Xbox360.

Estas estan compuestas por:

GPU: La GPU, —acrónimo de «graphics processing unit», que significa «unidad de procesamiento gráfico»— es un procesador (como la CPU) dedicado al procesamiento de gráficos; su razón de ser es aligerar la carga de trabajo del procesador central y, por ello, está optimizada para el cálculo en coma flotante, predominante en las funciones 3D. La mayor parte de la información ofrecida en la especificación de una tarjeta gráfica se refiere a las características de la GPU, pues constituye la parte más importante de la tarjeta gráfica, así como la principal determinante del rendimiento. Tres de las más importantes de dichas características son la frecuencia de reloj del núcleo, que en la actualidad oscila entre 500 MHz en las tarjetas de gama baja y 850 MHz en las de gama alta, el número de procesadores shaders y el número de pipelines (vertex y fragment shaders), encargadas de traducir una imagen 3D compuesta por vértices y líneas en una imagen 2D compuesta por pixels. Elementos generales de una GPU:

Shaders: Es elemento más notable de potencia de una GPU, estos shaders unificados reciben el nombre de núcleos CUDA en el caso de nvidia y Procesadores Stream en el caso de AMD. Son una evolución natural de los antiguos pixel shader (encargados de la rasterización de texturas) y vertex shader (encargados de la geometría de los objetos), los cuales anteriormente actuaban de forma independiente. Los shaders unificados son capaces de actuar tanto de vertex shader como de pixel shader según la demanda, aparecieron en el 2007 con los chips G90 de nvidia (Series 8000) y los chips R600 para AMD (Series HD 2000), antigua ATi, incrementando la potencia drásticamente respecto a sus familias anteriores

ROP: Se encargan de representar los datos procesados por la GPU en la pantalla, además también es el encargado de los filtros como Antialiasing.

Memoria gráfica de acceso aleatorio: Son chips de memoria que almacenan y transportan información entre sí, no son determinantes en el rendimiento máximo de la tarjeta gráfica, pero bien unas especificaciones reducidas pueden limitar la potencia de la GPU. Existen de dos tipos, Dedicada cuando, la tarjeta gráfica o la GPU dispone exclusivamente para sí esas memorias, ésta manera es la más eficiente y la que mejores resultados da; y compartida cuando se utiliza memoria en detrimento de la memoria RAM, ésta memoria es mucho más lenta que la dedicada y por tanto rinde mucho peor, es recurrente en campañas de márketing con mensajes tipo Tarjeta gráfica de "Hasta ~ MB" para engañar al consumidor haciéndole creer que la potencia de esa tarjeta gráfica reside en su cantidad de memoria.Las características de memoria gráfica de una tarjeta gráfica se expresan en 3 características:

Capacidad: La capacidad de la memoria determina el número máximo de datos y texturas procesadas, una capacidad insuficiente se traduce en un retardo a espera de que se vacíen esos datos. Sin embargo es un valor muy sobrevalorado como estrategia recurrente de márketing para engañar al consumidor, tratando de hacer creer que el rendimiento de una tarjeta gráfica se mide por la capacidad de su memoria; tal es ésta tendencia, que muchos ensambladores embuten ingentes cantidades de memoria con GPU incompatibles con dicha capacidad, resultando una pérdida notable de la velocidad de dichas memorias, dando como resultado una tarjeta gráfica mucho más lenta que la que contiene una memoria mucho más pequeña y suficiente al sector al que va a pertenecer la tarjeta gráfica y recomendado por el fabricante. Se mide en bytes

Interfaz de Memoria: También denominado Bus de datos, es la multiplicación resultante del de ancho de bits de cada chip por su número de unidades. Es una característica importante y determinante, junto a la velocidad de la memoria, a la cantidad de datos que puede transferir en un tiempo determinado, denominado ancho de banda. Una analogía al ancho de banda se podría asociar al ancho de una autopista o carriles y al número de vehículos que podrían circular a la vez. La interfaz de memoria se mide en bits.

Suscribirse a:

Comentarios (Atom)